색인된 문서를 알아보려 구글, Bing, 다음, 네이버에서 "site:www.xetown.com"을 검색해보았습니다.

1위 구글 : 3,620개

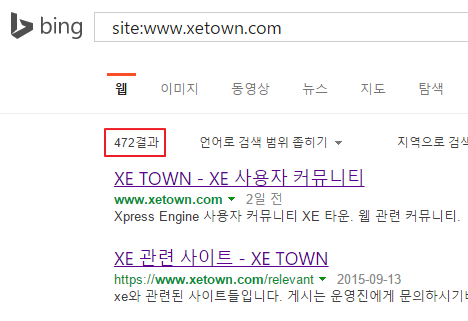

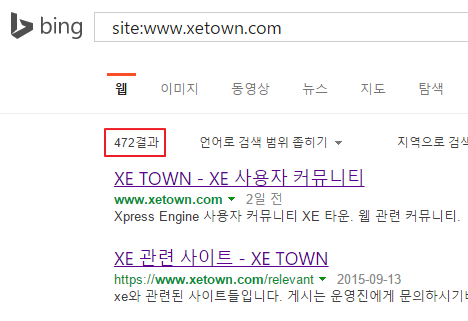

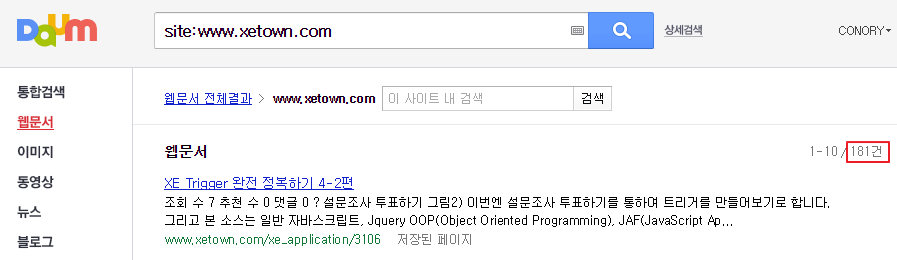

2위 Bing : 472개

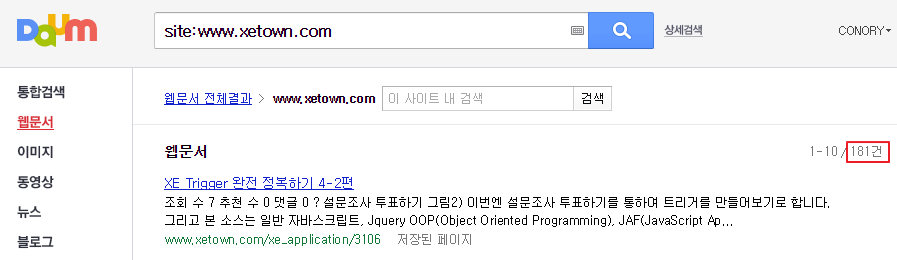

3위 다음 : 181개

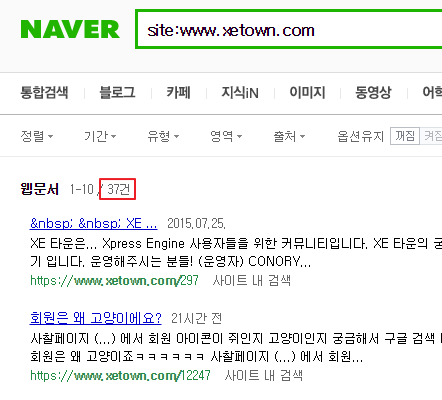

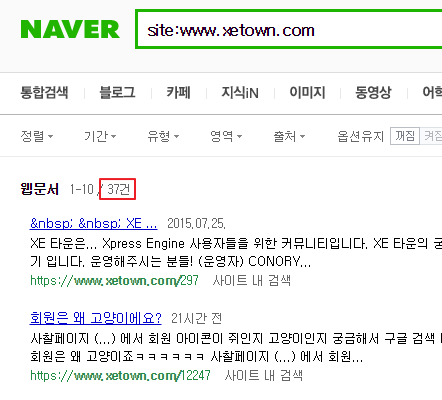

꼴지 네이버 : 37개 (신디 없으면 겨우 1개)

색인된 문서를 알아보려 구글, Bing, 다음, 네이버에서 "site:www.xetown.com"을 검색해보았습니다.

근데 이건 불가능한게 저희 같은 회원제 사이트의 경우 게시글 작성이 정회원이상인데요.. 비회원은 글 작성이 금지되어 있지 않나요?

윽.. 아니군요. 글 열람시 비밀번호군요..

총 게시물 수가 500개 정도인데 3,620개를 긁어간 구글은 대체 뭥미?

link rel="canonical"은 그냥 살포시 무시하는 건가요? ㅋㅋㅋ

실제 쓸모있는 결과 갯수는 빙이 제일 정직한 것 같네요 ^^

여러가지 주소형태 다 긁어가요. 구글은요... 방법이 하나 있긴 한데 ?표 들어간걸 못긁어가고 색인에서 제외처리 하면 되는데요.. 문제는 다국어적용하니 이 ?표가 필요해지더라구요. 그래서 저희 사이트는 깔끔한 주소만 노출하다가 최근 다국어 적용하고 나서 동일게시물이 여러개가 노출되는 불편을 다시 맞게 되었네요~

더 심하게 페이지별로 분류된 게시물주소까지... ㅋ 질려버리는 구글입니다 ㅋ

https://xetown.com/index.php?mid=lakepark&page=3&document_srl=7819

User-agent: GooglebotDisallow: /?*

Disallow: /*?

요게 맞을거에요. 제가 기억으로는 *가 붙으면 뒤에 어떤문자열이 와도 모두 포함하는 것으로 압니다.

robots.txt. 파일에 적용하면 크롤링이 저기 주소는 거부되구요.

이미 색인된 것이 있기에 그거 요청하려면 구글웹마스터도구에 보시면 색인제외 요청 하는 곳이 있습니다.

같은 형식으로 요청하시면 될거에요. (같은 형식이라합은 ?*)

네이버 신디연동해서 어제부터 색인된거 사라지는지 보세요. 길면 2~3일 정도에 사라져요. 사라진다면 저희 사이트랑 같은 케이스에요.